12 Kritische Sicherheitsrisiken von Shadow AI, die Ihre Organisation 2026 Überwachen Muss

Feb 13, 2026

Welche Daten geben Ihre Mitarbeiter in nicht genehmigte KI-Tools ein? Wenn Sie diese Frage nicht beantworten können, haben Sie möglicherweise Schatten-KI-Sicherheitsrisiken, von denen Sie nichts wissen.

Der Netwrix Cybersecurity Trends Report 2025 hat ergeben, dass 37 % der Organisationen bereits ihre Sicherheitsstrategien aufgrund von KI-gesteuerten Bedrohungen anpassen mussten, während 30 % noch nicht mit der Implementierung von KI begonnen haben. Diese Kluft zwischen der Geschwindigkeit, mit der sich KI-Bedrohungen entwickeln, und der Langsamkeit, mit der Organisationen reagieren, ist der Bereich, in dem Shadow AI gedeiht.

KI am Arbeitsplatz ist nicht das Problem. Es außerhalb genehmigter IT-Kanäle zu verwenden, ist es. Wenn Mitarbeiter KI-Tools ohne Aufsicht übernehmen, häufen sich die Risiken schnell: Datenlecks durch nicht geprüfte Modelle, Compliance-Lücken, die während Audits auftauchen, und Expositionswege, die Sicherheitsteams nicht überwachen können.

Je schneller Sie diese spezifischen Risiken benennen können, desto schneller können Sie eine Antwort entwickeln, die Ermöglichung und Schutz in Einklang bringt. In diesem Artikel führen wir Sie durch die Risiken der Schatten-KI-Sicherheit, die 12 Risiken, die Sie überwachen müssen, und wie Sie diese bewerten und priorisieren können.

TL;DR:

Shadow AI bringt Sicherheits- und Compliance-Risiken mit sich, wenn Mitarbeiter nicht genehmigte KI-Tools verwenden, die sensible Daten außerhalb der organisatorischen Kontrolle bewegen. Da die Einführung von KI die Governance überholt, sind Organisationen Risiken durch Datenlecks, Prüfungsdefizite, agentisches Verhalten und Angriffe auf Modelle ausgesetzt. Eine effektive Governance von Shadow AI erfordert Sichtbarkeit in Daten und Identität, risikobasierte Klassifizierung und Kontrollen, die eine sichere Nutzung von KI ermöglichen, ohne die Teams zu verlangsamen.

Was sind die Sicherheitsrisiken von Shadow AI?

Shadow AI ist ein Teilbereich von Shadow IT, der sich speziell auf die Nutzung von KI-Tools oder -Plattformen ohne Genehmigung oder Aufsicht der IT-Abteilung bezieht. Ein Sicherheitsrisiko von Shadow AI tritt auf, wann immer Unternehmensdaten durch KI-Tools und -Kanäle fließen, die die IT nicht sehen oder kontrollieren kann.

Shadow AI tritt im Allgemeinen auf, weil Mitarbeiter bestehende Systeme nutzen möchten, um ihre Arbeit zu beschleunigen. Wenn ein Vertriebsmitarbeiter jedoch eine Kundenliste mit Namen und E-Mails in ChatGPT einfügt, um personalisierte Kontaktanfragen zu entwerfen, leben diese Daten nun auf Servern außerhalb Ihres Sicherheitsperimeters. Dies führt zu Risiken, die Sicherheitsteams nicht überwachen oder mindern können.

Die Auswirkungen von Shadow-AI können erheblich sein. Organisationen mit hohem Shadow-AI-Einsatz erleben Durchschnittskosten für Datenverletzungen von 4,63 Millionen Dollar, was 670.000 Dollar mehr pro Verletzung bedeutet als bei denen mit geringem oder keinem Einsatz.

Hier ist, was das Management von Shadow AI schwierig macht:

- Es versteckt sich direkt vor unseren Augen: Shadow AI ist oft in Browsererweiterungen, Plugins oder KI-fähigen Funktionen innerhalb bereits genehmigter SaaS-Tools eingebettet, wodurch es für traditionelle IT-Entdeckungsmethoden unsichtbar wird.

- Es verarbeitet Daten über Eingabeaufforderungen: Im Gegensatz zu herkömmlicher Software erhalten Shadow-AI-Tools sensible Daten über natürliche Spracheingaben, die verarbeitet und möglicherweise auf Servern von Drittanbietern gespeichert werden.

- Traditionelle Rahmenwerke decken es nicht ab: Während Cybersicherheitsrahmen wie NIST CSF, ISO 27001 und CIS Controls weiterhin wesentliche Grundlagen sind, wurden sie nicht mit KI-spezifischen Datenflüssen im Hinterkopf entwickelt. Das bedeutet, dass die Erkennungsmethoden, Expositionswege und Governance-Anforderungen grundlegend anders sind als bei traditioneller Schatten-IT.

- Autonome Agenten fügen Komplexität hinzu: Shadow AI kann Agenten umfassen, die Entscheidungen treffen und Maßnahmen ergreifen, die über den einfachen Datenzugriff hinausgehen, was unvorhersehbare Sicherheitsrisiken schafft.

Diese Merkmale sind der Grund, warum Shadow-AI nicht mit dem gleichen Handbuch wie traditionelle Shadow-IT verwaltet werden kann. Die Erkennungsmethoden, Datenexpositionswege und Governance-Lücken sind alle unterschiedlich.

Die 12 kritischen Sicherheitsrisiken von Shadow AI

Sicherheitsrisiken von Shadow AI können unabhängig existieren, aber in der Praxis kumulieren sie. Ein Mitarbeiter, der ein persönliches KI-Konto verwendet, um regulierte Daten über ein Tool ohne Audit-Protokollierung zu verarbeiten, schafft beispielsweise eine Compliance-Exposition, die größer ist als jedes einzelne Risiko.

1. Unbefugte Datenexposition gegenüber KI-Modellen von Drittanbietern

Jede Eingabeaufforderung, die an ein KI-Modell eines Drittanbieters gesendet wird, sind Daten, die Ihre Umgebung verlassen. Es sei denn, das Tool wurde überprüft und genehmigt, haben Sie keine Kontrolle darüber, wie diese Daten gespeichert, für das Modelltraining verwendet oder aufbewahrt werden. Das ist das Kernrisiko: sensible Informationen, die zu Servern außerhalb Ihres Sicherheitsbereichs fließen, ohne dass Schutzmaßnahmen vorhanden sind.

Denken Sie darüber nach, was passiert, wenn Ihre Mitarbeiter Kundendaten in ChatGPT einfügen, um schneller eine Antwort zu entwerfen. Dieser Prompt könnte proprietären Code, Finanzprognosen, M&A-Dokumente oder Kunden-PII, die alle verarbeitet und möglicherweise auf Servern von Drittanbietern außerhalb Ihrer Kontrolle gespeichert werden.

2. Nutzung persönlicher Konten, die Unternehmenskontrollen umgehen

Dieses Risiko ist überraschend häufig, und die Mitarbeiter erkennen oft nicht den Unterschied zwischen ihren persönlichen und beruflichen KI-Konten. Wenn Mitarbeiter ihre persönlichen ChatGPT- oder Claude-Konten für berufliche Aufgaben verwenden, verlieren Sie die Sichtbarkeit, Prüfpfade, und jede Möglichkeit, Richtlinien zur Datenverarbeitung durchzusetzen.

3. Lücken im Governance-Rahmen

Die Einführung von KI-Tools übertrifft konstant die Governance-Rahmen, die zu ihrer Verwaltung gedacht sind. Wenn Mitarbeiter sich in wenigen Minuten für ein neues KI-Tool anmelden können, Ihr Genehmigungsprozess jedoch Wochen dauert, füllt sich die Lücke mit Schatten-KI.

Infolgedessen kann Ihr Sicherheitsteam keine Richtlinien für Werkzeuge durchsetzen, von denen sie nicht wissen, dass sie existieren, und Ihr Rechtsteam kann die Datenverarbeitungsbedingungen für Dienste, die niemand als angenommen gemeldet hat, nicht überprüfen.

4. Nicht genehmigte agentische KI- und Tool-Integrationen

Eine aufkommende Kategorie von Schatten-KI-Risiken umfasst nicht genehmigte KI-Modelle, Werkzeuge und autonome Agenten, die in Geschäftsabläufe integriert sind. Dazu gehören Plugins, Model Context Protocol (MCP)-Server und LangChain-Tools, die auf Produktionsdaten zugreifen können, die über Ihre Sicherheitssicht hinausgehen.

Im Gegensatz zur traditionellen Schatten-IT treffen diese Agenten autonome Entscheidungen, verknüpfen Aktionen über Systeme hinweg und können ihre eigenen Berechtigungen je nach Konfiguration erhöhen.

5. Angriffe durch Eingabeaufforderung

Prompt-Injektion nutzt einen grundlegenden Entwurfsfehler in großen Sprachmodellen aus: Benutzereingaben und Systemanweisungen werden als derselbe Datentyp verarbeitet. Ein Angreifer, der die richtige Eingabe erstellt, kann sensible Informationen extrahieren, KI-Ausgaben manipulieren oder unbefugte Aktionen auslösen, alles über eine Konversationsschnittstelle, die nicht für einen adversarialen Gebrauch konzipiert wurde.

6. Systemaufforderung Leckage, die Anmeldeinformationen offenbart

Wenn KI-Tools mit API-Schlüsseln, Datenbankanmeldeinformationen oder anderen Geheimnissen konfiguriert sind, die in ihren Systemaufforderungen eingebettet sind, können Angriffe auf die Eingabeaufforderung diese extrahieren. Eine konversationelle Schnittstelle wird zu einem Angriffsvektor, wenn die richtige Eingabe das Modell dazu bringt, Informationen preiszugeben, die verborgen bleiben sollten.

7. Vergiftung der KI-Lieferkette

Die KI-Lieferkette führt neue Risikowege durch bösartige Abhängigkeiten in vortrainierten Modellen, Datensätzen und ML-Frameworks ein. Diese zielen speziell auf KI-Entwickler und LLM-Integrationen ab und sind mit einer standardmäßigen Softwarekompositionsanalyse schwer zu erkennen.

Da Schatten-KI-Tools Ihren Auswahlprozess vollständig umgehen, hat Ihr Team keine Möglichkeit, die Herkunft von Modellen oder Trainingsdaten zu bewerten, bevor die Mitarbeiter beginnen, ihnen sensible Eingaben zu geben.

8. Hochrisikoanwendungen mit unzureichenden Sicherheitskontrollen

Shadow-AI-Anwendungen, die ohne IT-Prüfung übernommen werden, fehlen oft grundlegende Sicherheitskontrollen, einschließlich Verschlüsselung, Multi-Faktor-Authentifizierung, Audit-Protokollierung und Datenresidenzgarantien. Ohne diese Kontrollen sind sensible Daten, die über diese Tools verarbeitet werden, weder im Ruhezustand noch während der Übertragung geschützt.

9. Lücken in den Nachweisen zur Einhaltung für KI-spezifische Kontrollen

Ihr bestehendes Compliance-Programm generiert wahrscheinlich Beweise für Zugriffskontrollen, Änderungsmanagement und Datenverarbeitung. Aber wenn Auditoren fragen, wie Sie die Nutzung von KI-Tools steuern, welche Daten Mitarbeiter über KI-Eingabeaufforderungen senden oder wie Sie das Verhalten von KI-Agenten überwachen, haben die meisten Organisationen nichts vorzuzeigen.

Diese Lücke tritt nur auf, wenn jemand danach fragt, und bis dahin ist das Audit-Ergebnis bereits geschrieben.

10. Unzureichendes Protokollieren und Sichtbarkeit

Ohne eine Protokollierungsinfrastruktur für KI-Interaktionen können Sie anomales Verhalten nicht erkennen oder effektive Vorfalluntersuchungen durchführen. Unzureichendes Audit-Logging verstößt gegen die PCI DSS-Anforderung 10, die Anforderungen an die Auditkontrollen von HIPAA (45 CFR §164.312(b)) und SOC 2 CC7.2.

11. KI-Agenten, Plugins und Browsererweiterungen

KI-Agenten, Browsererweiterungen und Plugins bringen Risiken auf der Integrationsebene mit sich. Jeder arbeitet mit seinen eigenen Berechtigungen, verbindet sich mit externen Systemen und verarbeitet Daten auf eine Weise, die schwer im großen Maßstab zu überwachen ist.

Eine Erweiterung, die umfassende Berechtigungen anfordert, kann auf Sitzungstoken zugreifen, Seiteninhalte lesen oder Daten über Hintergrundverbindungen exfiltrieren, und die meisten Organisationen haben keine Sichtbarkeit darüber, welche Erweiterungen die Mitarbeiter installiert haben.

12. Kontamination des geistigen Eigentums und algorithmische Voreingenommenheit

Die Nutzung von Shadow-AI schafft Risiken für das geistige Eigentum, da proprietäre Daten kommerzielle Modelle außerhalb der organisatorischen Kontrolle trainieren. Wenn Mitarbeiter Quellcode, Produkt-Roadmaps oder Kundendaten in nicht genehmigte KI-Tools einfügen, können diese Informationen in das Modelltraining einfließen und damit potenziell für andere Benutzer oder Wettbewerber zugänglich werden.

Separat stehen Organisationen vor der Haftung für algorithmische Voreingenommenheit, wenn Mitarbeiter nicht autorisierte KI-Tools für Einstellungsentscheidungen oder kundenorientierte Interaktionen verwenden. Die Organisation kann für diskriminierende Ergebnisse verantwortlich gemacht werden, unabhängig davon, ob die Führungskraft das Tool genehmigt hat, wodurch nicht genehmigte KI eine rechtliche Exposition darstellt, die weit über die Datensicherheit hinausgeht.

Wie man Schatten-AI-Risiken bewertet und priorisiert

Wenn Ihre Organisation noch keine formelle IT-Risikoanalyse hat, fangen Sie dort an. Aber Shadow AI bringt Risiken mit sich, die traditionelle Rahmenwerke nicht erfassen konnten, daher benötigen Sie eine spezifische Schicht für KI.

Das NIST AI Risk Management Framework bietet diese Struktur durch vier Funktionen: Govern, Map, Measure und Manage. Beginnen Sie damit, entdeckte Tools nach dem Risiko der Datenverarbeitung zu klassifizieren:

- Kritisches Risiko: Werkzeuge, die regulierte Daten (PCI, PHI, PII) verarbeiten. Erfordern sofortige Maßnahmen.

- Hohes Risiko: Werkzeuge mit Zugriff auf proprietäre Geschäftsdaten. Erfordern Bewertung und Kontrollen.

- Mittleres Risiko: Werkzeuge, die interne, aber nicht sensible Daten verarbeiten. Erfordern eine Richtlinienabdeckung.

- Geringes Risiko: Werkzeuge ohne Zugriff auf sensible Daten. Erfordern nur Überwachung.

Nachdem Sie jedes Tool nach dem Risiko der Datenverarbeitung klassifiziert haben, besteht der nächste Schritt darin, diese Klassifikationen mit den spezifischen Compliance-Anforderungen abzugleichen, denen Ihre Organisation unterliegt.

Hier ist der Ort, an dem die Schatten-KI die schärfste Prüfungsrisiko schafft: ein als "kritisches Risiko" klassifiziertes Tool, das Kartendaten verarbeitet und beispielsweise spezifische Protokollierungs- und Zugriffskontrollvorgaben auslöst, die Sie nicht erfüllen können, wenn Sie nicht wissen, dass das Tool existiert.

Für regulierte Branchen, ordnen Sie entdeckte Schatten-KI-Tools spezifischen Compliance-Anforderungen zu:

- Anforderung 10 des PCI DSS verlangt die Protokollierung des Zugriffs auf Karteninhaberdatenumgebungen

- HIPAA-Auditkontrollen (45 CFR §164.312(b)) erfordern die Verfolgung des Zugriffs auf PHI

- SOC 2 CC7.2 erfordert die Überwachung von Systemkomponenten auf Anomalien

- Artikel 28 der DSGVO erfordert dokumentierte Datenverarbeitungsvereinbarungen mit jedem Auftragsverarbeiter, der personenbezogene Daten verarbeitet

Ein sichtbarkeitsorientiertes Governance-Modell bietet die praktischste Reihenfolge: Alle verwendeten KI-Tools erkennen, sie nach Datenhandhabungsrisiko klassifizieren, Hochrisiko-Tools einschränken und sichere genehmigte KI-Alternativen bereitstellen.

Sichern von Shadow-AI-Agenten, Plugins und Integrationen

Laut der Implementierungsstudie von McKinsey, 80 % der Organisationen haben bereits riskante Verhaltensweisen von KI-Agenten erlebt, einschließlich unangemessener Datenexposition und unbefugtem Systemzugriff.

Die Integrationsschicht ist der Ort, an dem Sie die meiste Kontrolle haben. Hier ist der Ausgangspunkt:

- Implementieren eine Minimalprivilegien-Architektur für KI-Agenten: Die Berechtigungen der Agenten auf die spezifischen Systeme und Daten beschränken, die für ihre definierten Aufgaben erforderlich sind. Ein Kundenservice-Agent sollte nur auf Ticketdaten und Wissensdatenbanken zugreifen, nicht auf Finanzsysteme oder Personalakten. Überprüfen und dokumentieren Sie jede Berechtigungsvergabe und implementieren Sie zeitlich begrenzten Zugriff, der automatisch abläuft.

- Vet plugins and extensions before deployment: Before approving any AI plugin or browser extension, evaluate the vendor's security practices, data handling policies, and permission requirements. Look for extensions requesting broad permissions beyond what their stated function requires, unclear data retention policies, or vendors without documented security certifications.

- Durchsetzen von Browsererweiterungskontrollen: Eine Zulassungsliste für genehmigte Browsererweiterungen über Gruppenrichtlinien oder Endpoint-Management implementieren. Überwachen Sie nicht autorisierte Erweiterungsinstallationen und erstellen Sie Warnungen, wenn neue, KI-bezogene Erweiterungen auf verwalteten Geräten erscheinen.

- Sichern Sie die Server des Modellkontextprotokolls und die LangChain-Tools: Diese Integrationspunkte können auf Produktionsdaten zugreifen, die über Ihre Sicherheitssichtbarkeit hinausgehen. Implementieren Sie das Protokollieren aller Agentenaktionen, überwachen Sie Datenzugriffsmuster, die das erwartete Verhalten überschreiten, und verlangen Sie eine Sicherheitsüberprüfung, bevor Sie eine neue Integration mit Unternehmenssystemen verbinden.

- Protokollieren Sie die Aktionen der Agenten umfassend:Da viele Unternehmen die Nutzung von Daten durch KI-Agenten nicht verfolgen können, implementieren Sie eine detaillierte Protokollierung, die erfasst, auf welche Daten jeder Agent zugreift, welche Aktionen er ausführt und mit welchen externen Systemen er sich verbindet. Diese Protokollierung ist sowohl für die Sicherheitsüberwachung als auch als Nachweis für die Einhaltung von Vorschriften unerlässlich.

All dies manuell in einer hybriden Umgebung zu tun, ist der Punkt, an dem die meisten Teams ins Stocken geraten. Die oben genannten Kontrollen sind klar, aber ihre Ausführung erfordert Sichtbarkeit sowohl in Ihre Daten als auch in Ihre Identitäten in einer einzigen Ansicht.

Wie Netwrix die Sicherheit von Shadow AI unterstützt

Die Governance von Shadow AI bricht zusammen, wenn Sie Ihre Daten sehen können, aber nicht wissen, wer darauf zugreift, oder wenn Sie Identitäten verfolgen können, aber nicht, welche sensiblen Daten sie berühren. Sie benötigen beide Ansichten gleichzeitig, und das ist das Problem, das Netwrix löst.

Die Netwrix-Plattform bietet ein Daten-Sicherheits-Posture-Management (DSPM) durch 1Secure und Datenentdeckung und -klassifizierung durch Access Analyzer, das sensible Daten in hybriden Umgebungen abdeckt, einschließlich Quellen, die von Microsoft-nativen Tools nicht erreicht werden, wie NetApp-Speicherarrays und Amazon S3-Buckets über die mehr als 40 Datenmoduls von Access Analyzer.

Für Shadow-AI bietet 1Secure speziell Sichtbarkeit in die Exposition von Microsoft Copilot, indem es berichtet, auf welche sensiblen Daten Copilot zugreifen kann, und Risikobewertungen bereitstellt, um informierte Entscheidungen über die Einführung von KI zu unterstützen.

Auf der Identitätsseite, die Identitätsbedrohungserkennung und -reaktion von Netwrix (ITDR) Fähigkeiten zeigen ungewöhnliche Datenzugriffsspitzen, Berechtigungsänderungen oder fehlgeschlagene Authentifizierungsmuster, die auf die Nutzung von Schatten-KI-Tools hinweisen könnten.

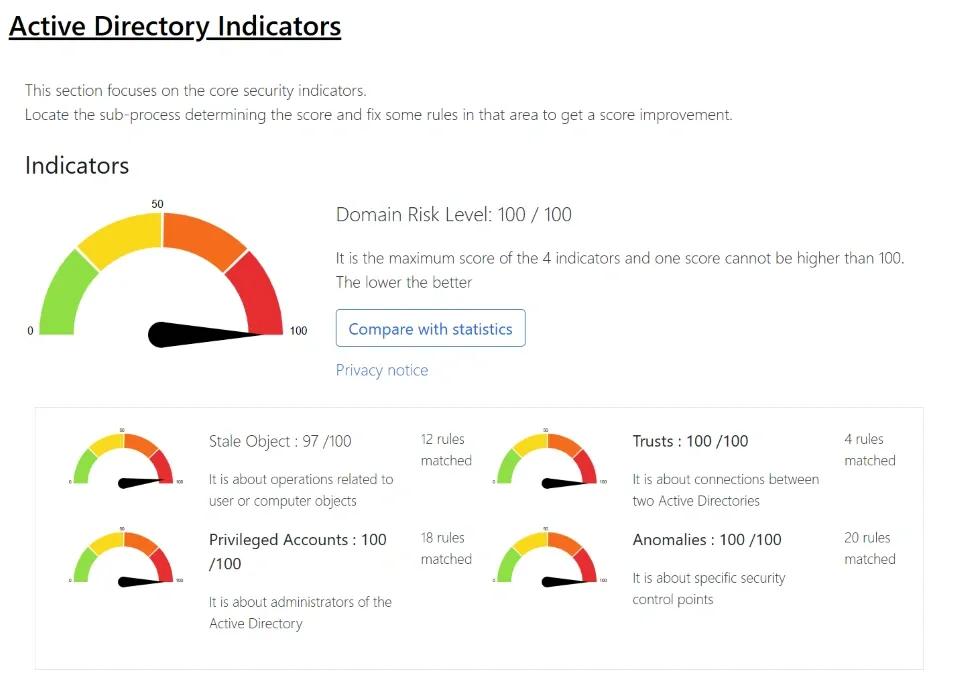

Risikobewertungs-Dashboards heben die Probleme der Identitäts-Hygiene hervor, die Shadow-AI gefährlicher machen. Denken Sie an inaktive Konten, übermäßige Berechtigungen und Synchronisierungsprobleme zwischen der lokalen Active Directory und Entra ID.

Netwrix ist für eine schnelle Wertschöpfung konzipiert. 1Secure liefert ab dem ersten Tag hochwirksame Ergebnisse ohne komplexe Implementierungen, während Netwrix Auditor sofort einsatzbereite, menschenlesbare Berichte bereitstellt, damit die Teams Auditfragen zum Zugriff auf KI-bezogene Daten in Minuten anstatt in Stunden beantworten können.

Die Compliance-Berichterstattung bezieht sich direkt auf die PCI DSS-, HIPAA-, SOC 2-, GDPR- und CMMC-Rahmenwerke, sodass der Nachweis, den Ihr Prüfer anfordert, ein Bericht ist und kein manueller Nachweissammelprozess.

Wenn Ihr Team Sichtbarkeit in Bezug auf Schatten-KI-Risiken benötigt, aber nicht auf ein sechsmonatiges Implementierungsprojekt warten kann, benötigen Sie eine Plattform, die ab dem ersten Tag Antworten liefert.Fordern Sie eine Netwrix-Demo an um zu beginnen.

Häufig gestellte Fragen zu den Sicherheitsrisiken von Shadow AI

Wie sollten wir mit Mitarbeitern umgehen, die persönliche KI-Konten für die Arbeit nutzen?

Die Nutzung persönlicher KI-Konten stellt einen erheblichen Datenexpositionsweg dar. Anstatt auf strafende Ansätze zu setzen, konzentrieren Sie sich darauf, zu verstehen, warum Mitarbeiter persönliche Konten bevorzugen, und beheben Sie diese Lücken.

Häufige Gründe sind schnellerer Zugang, bessere Funktionen oder Frustration über die Genehmigungsprozesse von Unternehmenswerkzeugen. Bieten Sie Unternehmens-KI-Alternativen an, die den Fähigkeiten persönlicher Werkzeuge entsprechen, optimieren Sie Ihren Genehmigungsprozess für neue KI-Funktionen und kommunizieren Sie klar über die Risiken, ohne eine Kultur der Angst zu schaffen.

Können wir KI-Tools einfach auf Netzwerkebene blockieren?

Sie können bekannte KI-Domains an der Firewall oder am Proxy blockieren, aber das wird das Problem nicht lösen. Neue KI-Tools werden ständig eingeführt, viele arbeiten auf gemeinsam genutzter Infrastruktur wie AWS und Azure, die Sie nicht pauschal blockieren können, und KI-Funktionen sind zunehmend in Tools integriert, die Sie bereits genehmigt haben.

Eine SaaS-Plattform, die Ihr Team täglich nutzt, könnte über Nacht einen KI-Assistenten hinzufügen, ohne Sie zu benachrichtigen. Das Blockieren führt auch dazu, dass die Nutzung im Verborgenen erfolgt: Mitarbeiter wechseln zu mobilen Geräten in persönlichen Netzwerken, was Ihre Sichtbarkeit vollständig beseitigt.

Zählt Microsoft Copilot als Schatten-KI, wenn wir es lizenziert haben?

Nicht, wenn es mit absichtlicher Governance bereitgestellt wurde, aber es kann dennoch Risiken ähnlich wie bei Schatten-KI schaffen. Copilot erbt alle Berechtigungen, die Benutzer bereits in Ihrer Microsoft-Umgebung haben. Wenn Ihr Berechtigungsmodell zu großzügig ist, kann Copilot sensible Daten sichtbar machen, auf die Benutzer technisch Zugriff hatten, die sie jedoch manuell niemals gefunden hätten.

Das ist keine Schatten-KI im traditionellen Sinne, aber das Ergebnis der Datenexposition ist dasselbe. Bevor Sie Copilot einführen, überprüfen Sie, wer auf was zugreifen kann, und bereinigen Sie zuerst übermäßige Berechtigungen.

Was ist das erste, was ich tun sollte, wenn wir heute kein Shadow-AI-Programm haben?

Beginnen Sie mit der Entdeckung, nicht mit der Politik. Eine akzeptable Nutzungspolitik zu schreiben, bevor Sie verstehen, welche Tools die Mitarbeiter tatsächlich verwenden und warum, führt zu Richtlinien, die ignoriert werden.

Überprüfen Sie Ihre DNS- und Proxy-Protokolle auf Verbindungen zu bekannten KI-Domains, überprüfen Sie die OAuth-Anwendungszustimmungen in Entra ID und führen Sie eine anonyme Umfrage durch, in der Sie die Mitarbeiter fragen, welche KI-Tools sie verwenden und welche Probleme diese Tools lösen.

Das gibt Ihnen ein realistisches Bild, um Governance aufzubauen, anstatt einen theoretischen Rahmen, dem niemand folgt.

Wie kann ich die Argumentation für die Governance von Shadow AI gegenüber der Führungsebene vorbringen?

Frame it in terms leadership already cares about: compliance risk, data exposure liability, and audit readiness. Most boards and executive teams don't need convincing that AI adoption is happening.

Sie müssen verstehen, dass die unkontrollierte Einführung von KI Beweislücken schafft, die Auditoren finden werden, Datenhandelsrisiken, die Regulierungsbehörden bestrafen werden, und eine Exposition geistigen Eigentums, die Wettbewerber ausnutzen könnten.

Bringen Sie spezifische Beispiele aus Ihrer eigenen Umgebung, wenn Sie können, sogar anekdotische aus der Entdeckungsphase, die mehr Gewicht haben als Branchendaten.

Teilen auf

Erfahren Sie mehr

Über den Autor

Dirk Schrader

VP of Security Research

Dirk Schrader ist Resident CISO (EMEA) und VP of Security Research bei Netwrix. Als 25-jähriger Veteran in der IT-Sicherheit mit Zertifizierungen als CISSP (ISC²) und CISM (ISACA) arbeitet er daran, die Cyber-Resilienz als modernen Ansatz zur Bekämpfung von Cyber-Bedrohungen voranzutreiben. Dirk hat an Cybersecurity-Projekten auf der ganzen Welt gearbeitet, beginnend in technischen und Support-Rollen zu Beginn seiner Karriere und dann übergehend in Vertriebs-, Marketing- und Produktmanagementpositionen sowohl bei großen multinationalen Konzernen als auch bei kleinen Startups. Er hat zahlreiche Artikel über die Notwendigkeit veröffentlicht, Änderungs- und Schwachstellenmanagement anzugehen, um Cyber-Resilienz zu erreichen.

Erfahren Sie mehr zu diesem Thema

Nicht-menschliche Identitäten (NHI) erklärt und wie man sie sichert

Datenschutzgesetze der Bundesstaaten: Unterschiedliche Ansätze zum Datenschutz

Was ist elektronisches Records Management?

Reguläre Ausdrücke für Anfänger: Wie man beginnt, sensible Daten zu entdecken

Externe Freigabe in SharePoint: Tipps für eine kluge Implementierung