12 Rischi Critici di Sicurezza di Shadow AI che la Tua Organizzazione Deve Monitorare nel 2026

Feb 13, 2026

Quali dati stanno inserendo i tuoi dipendenti in strumenti di IA non approvati? Se non puoi rispondere a questa domanda, potresti avere rischi di sicurezza dell'IA non visibili di cui non sei a conoscenza.

Il Netwrix Cybersecurity Trends Report 2025 ha rilevato che il 37% delle organizzazioni ha già dovuto adattare le proprie strategie di sicurezza a causa delle minacce guidate dall'IA, mentre il 30% non ha ancora avviato l'implementazione dell'IA. Quel divario tra la velocità con cui evolvono le minacce dell'IA e la lentezza con cui le organizzazioni stanno rispondendo è dove prospera l'IA ombra.

IA al lavoro non è il problema. Usarlo al di fuori dei canali approvati dall'IT lo è. Quando i dipendenti adottano strumenti di IA senza supervisione, i rischi si accumulano rapidamente: perdite di dati attraverso modelli non verificati, lacune di conformità che emergono durante le audit e percorsi di esposizione che i team di sicurezza non possono monitorare.

Più velocemente puoi nominare quei rischi specifici, più velocemente puoi costruire una risposta che bilanci l'abilitazione con la protezione. In questo articolo, ti guideremo attraverso quali sono i rischi di sicurezza dell'IA ombra, i 12 rischi che devi monitorare e come valutarli e priorizzarli.

TL;DR:

La Shadow AI introduce rischi di sicurezza e conformità quando i dipendenti utilizzano strumenti di IA non approvati che spostano dati sensibili al di fuori del controllo organizzativo. Poiché l'adozione dell'IA supera la governance, le organizzazioni affrontano esposizione a perdite di dati, lacune di audit, comportamento agentico e attacchi a livello di modello. Una governance efficace della Shadow AI richiede visibilità sui dati e sull'identità, classificazione basata sul rischio e controlli che consentano un uso sicuro dell'IA senza rallentare i team.

Quali sono i rischi per la sicurezza dell'IA ombra?

Shadow AI è un sottoinsieme di shadow IT che si riferisce specificamente all'uso di strumenti o piattaforme di IA senza l'approvazione o la supervisione del dipartimento IT. Un rischio di sicurezza di shadow AI si verifica ogni volta che i dati aziendali passano attraverso strumenti e canali di IA che l'IT non può vedere o controllare.

L'IA ombra generalmente si verifica perché i dipendenti vogliono sfruttare i sistemi esistenti per accelerare il proprio lavoro. Ma quando un rappresentante commerciale incolla un elenco di clienti con nomi e email in ChatGPT per redigere messaggi di contatto personalizzati, quei dati ora risiedono su server al di fuori del tuo perimetro di sicurezza. Questo introduce rischi che i team di sicurezza non possono monitorare o mitigare.

Le ripercussioni dell'IA ombra possono essere gravi. Le organizzazioni con un alto utilizzo di IA ombra sperimentano costi di violazione che mediamente ammontano a 4,63 milioni di dollari, che sono 670.000 dollari in più per violazione rispetto a quelle con basso o nessun utilizzo.

Ecco cosa rende difficile gestire l'IA ombra:

- Si nasconde in bella vista: Shadow AI è spesso integrato in estensioni del browser, plugin o funzionalità abilitate per l'IA all'interno di strumenti SaaS già approvati, rendendolo invisibile ai metodi tradizionali di scoperta IT.

- Elabora dati tramite prompt: A differenza del software tradizionale, gli strumenti di AI shadow ricevono dati sensibili tramite input in linguaggio naturale che vengono elaborati e potenzialmente memorizzati su server di terze parti.

- I framework tradizionali non lo coprono: Mentre i framework di cybersecurity come NIST CSF, ISO 27001 e CIS Controls rimangono fondamenta essenziali, non sono stati progettati tenendo presente flussi di dati specifici per l'IA. Questo significa che i metodi di rilevamento, le vie di esposizione e i requisiti di governance sono fondamentalmente diversi da quelli della shadow IT tradizionale.

- Gli agenti autonomi aggiungono complessità: L'IA ombra può includere agenti che prendono decisioni e compiono azioni oltre il semplice accesso ai dati, creando un'esposizione alla sicurezza imprevedibile.

Queste caratteristiche sono il motivo per cui l'IA in ombra non può essere gestita con lo stesso manuale della tradizionale IT in ombra. I metodi di rilevamento, i percorsi di esposizione dei dati e le lacune di governance sono tutti diversi.

I 12 rischi critici per la sicurezza dell'IA ombra

I rischi per la sicurezza dell'IA ombra possono esistere in modo indipendente, ma in pratica si accumulano. Un dipendente che utilizza un account personale di IA per elaborare dati regolamentati tramite uno strumento senza registrazione di audit, ad esempio, crea un'esposizione alla conformità che è maggiore di qualsiasi singolo rischio.

1. Esposizione non autorizzata dei dati a modelli di IA di terze parti

Ogni richiesta inviata a un modello di IA di terze parti è un dato che lascia il tuo ambiente. A meno che lo strumento non sia stato verificato e approvato, non hai controllo su come quei dati vengono memorizzati, utilizzati per l'addestramento del modello o conservati. Questo è il rischio principale: informazioni sensibili che fluiscono verso server al di fuori del tuo perimetro di sicurezza senza protezioni in atto.

Pensa a cosa succede quando i tuoi dipendenti incollano dati dei clienti in ChatGPT per redigere una risposta più velocemente. Quel prompt potrebbe contenere codice proprietario, proiezioni finanziarie, documenti di M&A, o PII dei clienti, tutto ciò viene elaborato e potenzialmente memorizzato su server di terze parti al di fuori del tuo controllo.

2. Utilizzo di account personali eludendo i controlli aziendali

Questo rischio è sorprendentemente comune e i dipendenti spesso non si rendono conto della differenza tra i loro account AI personali e lavorativi. Quando i dipendenti utilizzano i loro account personali di ChatGPT o Claude per compiti lavorativi, perdi visibilità, tracce di audit, e qualsiasi capacità di far rispettare le politiche di gestione dei dati.

3. Lacune nel framework di governance

L'adozione degli strumenti di IA supera costantemente i framework di governance destinati a gestirli. Quando i dipendenti possono registrarsi per un nuovo strumento di IA in pochi minuti, ma il processo di approvazione richiede settimane, il divario si riempie di IA ombra.

Di conseguenza, il tuo team di sicurezza non può far rispettare le politiche su strumenti di cui non sa che esistono, e il tuo team legale non può rivedere i termini di gestione dei dati per servizi che nessuno ha segnalato di aver adottato.

4. Integrazioni di IA e strumenti non autorizzati

Una categoria emergente di rischio IA ombra comprende modelli di IA non autorizzati, strumenti e agenti autonomi integrati nei flussi di lavoro aziendali. Ciò include plugin, server del Protocollo di Contesto del Modello (MCP) e strumenti LangChain che possono accedere ai dati di produzione oltre la tua visibilità di sicurezza.

A differenza della tradizionale shadow IT, questi agenti prendono decisioni autonome, concatenano azioni tra i sistemi e possono aumentare i propri privilegi a seconda di come sono configurati.

5. Attacchi di iniezione di comandi

Iniezione di prompt sfrutta un difetto di design fondamentale nei modelli di linguaggio di grandi dimensioni: l'input dell'utente e le istruzioni di sistema vengono elaborati come lo stesso tipo di dati. Un attaccante che crea l'input giusto può estrarre informazioni sensibili, manipolare le uscite dell'IA o attivare azioni non autorizzate, il tutto attraverso un'interfaccia conversazionale che non è stata progettata con un uso avversariale in mente.

6. Perdita di prompt di sistema che espone credenziali

Quando gli strumenti di IA sono configurati con chiavi API, credenziali di database o altri segreti incorporati nei loro messaggi di sistema, gli attacchi di ingegneria dei messaggi possono estrarli. Un'interfaccia conversazionale diventa un vettore di attacco quando l'input corretto fa sì che il modello riveli informazioni che avrebbero dovuto rimanere nascoste.

7. Avvelenamento della catena di fornitura dell'IA

La catena di approvvigionamento dell'IA introduce nuove vie di rischio attraverso dipendenze dannose in modelli pre-addestrati, set di dati e framework di ML. Questi mirano specificamente agli sviluppatori di IA e alle integrazioni LLM, e sono difficili da rilevare con l'analisi standard della composizione del software.

Poiché gli strumenti di IA shadow eludono completamente il tuo processo di valutazione, il tuo team non ha l'opportunità di valutare la provenienza dei modelli o dei dati di addestramento prima che i dipendenti inizino a fornire loro input sensibili.

8. Applicazioni ad alto rischio con controlli di sicurezza inadeguati

Le applicazioni di IA Shadow adottate senza la verifica IT spesso mancano di controlli di sicurezza fondamentali, tra cui crittografia, autenticazione a più fattori, registrazione delle audit e garanzie di residenza dei dati. Senza questi controlli, i dati sensibili elaborati tramite questi strumenti non hanno protezione a riposo o in transito.

9. Lacune nelle prove di conformità per controlli specifici per l'IA

Il tuo programma di conformità esistente probabilmente genera prove per controlli di accesso, gestione delle modifiche e gestione dei dati. Ma quando gli auditor chiedono come governi l'uso degli strumenti di IA, quali dati inviano i dipendenti tramite i messaggi di IA o come monitori il comportamento degli agenti di IA, la maggior parte delle organizzazioni non ha nulla da mostrare.

Questa lacuna emerge solo quando qualcuno la richiede, e a quel punto, il risultato dell'audit è già scritto.

10. Registrazione e visibilità inadeguate

Senza un'infrastruttura di registrazione per le interazioni AI, non puoi rilevare comportamenti anomali o condurre indagini sugli incidenti in modo efficace. Un registro di audit inadeguato viola il Requisito 10 del PCI DSS, il requisito di controlli di audit dell'HIPAA (45 CFR §164.312(b)) e SOC 2 CC7.2.

11. Agenti AI, plugin ed estensioni del browser

Gli agenti AI, le estensioni del browser e i plugin introducono rischi a livello di integrazione. Ognuno opera con i propri permessi, si connette a sistemi esterni e elabora dati in modi difficili da monitorare su larga scala.

Un'estensione che richiede ampie autorizzazioni può accedere ai token di sessione, leggere il contenuto della pagina o esfiltrare dati tramite connessioni in background, e la maggior parte delle organizzazioni non ha visibilità su quali estensioni i dipendenti hanno installato.

12. Contaminazione della proprietà intellettuale e pregiudizio algoritmico

L'uso dell'IA ombra crea rischi di proprietà intellettuale poiché i dati proprietari addestrano modelli commerciali al di fuori del controllo organizzativo. Quando i dipendenti incollano codice sorgente, roadmap di prodotto o dati dei clienti in strumenti di IA non approvati, tali informazioni possono essere incorporate nell'addestramento del modello, rendendole potenzialmente accessibili ad altri utenti o concorrenti.

Separatamente, le organizzazioni affrontano la responsabilità per pregiudizi algoritmici se i dipendenti utilizzano strumenti di IA non autorizzati per decisioni di assunzione o interazioni con i clienti. L'organizzazione può essere ritenuta responsabile per risultati discriminatori indipendentemente dal fatto che la leadership abbia approvato lo strumento, rendendo l'IA non autorizzata un'esposizione legale che si estende ben oltre la sicurezza dei dati.

Come valutare e dare priorità ai rischi dell'IA ombra

Se la tua organizzazione non ha ancora una valutazione del rischio IT formale, inizia da lì. Ma l'IA ombra introduce rischi che i framework tradizionali non sono stati progettati per rilevare, quindi avrai bisogno di uno strato specifico per l'IA.

Il Quadro di Gestione del Rischio AI NIST fornisce quella struttura attraverso quattro funzioni: Governare, Mappare, Misurare e Gestire. Inizia classificando gli strumenti scoperti in base al rischio di gestione dei dati:

- Rischio critico: Strumenti che elaborano dati regolamentati (PCI, PHI, PII). Richiedono azione immediata.

- Alto rischio: Strumenti con accesso a dati aziendali riservati. Richiedono valutazione e controlli.

- Rischio medio: Strumenti che elaborano dati interni ma non sensibili. Richiedono copertura politica.

- Basso rischio: Strumenti senza accesso a dati sensibili. Richiedono solo monitoraggio.

Una volta che hai classificato ogni strumento in base al rischio di gestione dei dati, il passo successivo è mappare quelle classificazioni rispetto ai requisiti di conformità specifici a cui è soggetta la tua organizzazione.

Qui è dove l'IA ombra crea l'esposizione di audit più acuta: uno strumento classificato come "rischio critico" che elabora i dati dei titolari di carte, ad esempio, attiva specifici mandati di registrazione e controllo degli accessi che non puoi soddisfare se non sai che lo strumento esiste.

Per le industrie regolamentate, mappa gli strumenti di IA in ombra scoperti rispetto ai requisiti di conformità specifici:

- Requisito 10 del PCI DSS richiede la registrazione dell'accesso agli ambienti dei dati dei titolari di carta

- Controlli di audit HIPAA (45 CFR §164.312(b)) richiedono il tracciamento dell'accesso a PHI

- SOC 2 CC7.2 richiede il monitoraggio dei componenti del sistema per anomalie

- Articolo 28 del GDPR richiede accordi di elaborazione dei dati documentati con qualsiasi elaboratore che gestisce dati personali

Un modello di governance incentrato sulla visibilità fornisce la sequenza più pratica: rilevare tutti gli strumenti di IA in uso, classificarli in base al rischio di gestione dei dati, limitare gli strumenti ad alto rischio e fornire alternative di IA approvate e sicure.

Proteggere gli agenti di IA shadow, i plugin e le integrazioni

Secondo lo studio di implementazione di McKinsey, l'80% delle organizzazioni ha già incontrato comportamenti rischiosi da parte degli agenti IA, inclusa l'esposizione impropria dei dati e l'accesso non autorizzato al sistema.

Lo strato di integrazione è dove hai il massimo controllo. Ecco da dove iniziare:

- Implementare architettura a privilegio minimo per agenti AI: Limitare i permessi degli agenti solo ai sistemi e ai dati specifici richiesti per i loro compiti definiti. Un agente del servizio clienti dovrebbe accedere solo ai dati dei ticket e alle basi di conoscenza, non ai sistemi finanziari o ai registri delle risorse umane. Rivedere e documentare ogni concessione di permesso e implementare un accesso limitato nel tempo che scade automaticamente.

- Vet plugins and extensions before deployment: Before approving any AI plugin or browser extension, evaluate the vendor's security practices, data handling policies, and permission requirements. Look for extensions requesting broad permissions beyond what their stated function requires, unclear data retention policies, or vendors without documented security certifications.

- Applicare i controlli delle estensioni del browser: Implementare una lista di autorizzazione per le estensioni del browser approvate tramite criteri di gruppo o gestione degli endpoint. Monitorare le installazioni di estensioni non autorizzate e creare avvisi quando nuove estensioni relative all'IA appaiono sui dispositivi gestiti.

- Proteggi i server del Protocollo di Contesto del Modello e gli strumenti LangChain: Questi punti di integrazione possono accedere ai dati di produzione oltre la tua visibilità di sicurezza. Implementa la registrazione per tutte le azioni degli agenti, monitora i modelli di accesso ai dati che superano il comportamento previsto e richiedi una revisione della sicurezza prima di connettere qualsiasi nuova integrazione ai sistemi aziendali.

- Registra le azioni degli agenti in modo completo:Poiché molte aziende non possono monitorare l'uso dei dati degli agenti AI, implementa un logging dettagliato che catturi quali dati accede ciascun agente, quali azioni intraprende e a quali sistemi esterni si connette. Questo logging è essenziale sia per il monitoraggio della sicurezza che come prova di conformità.

Fare tutto questo manualmente in un ambiente ibrido è dove la maggior parte dei team si ferma. I controlli sopra sono chiari, ma eseguirli richiede visibilità sia sui tuoi dati che sulle tue identità in un'unica vista.

Come Netwrix supporta la sicurezza dell'IA ombra

La governance dell'IA Shadow si interrompe quando puoi vedere i tuoi dati ma non chi vi accede, o quando puoi tracciare le identità ma non quali dati sensibili stanno toccando. Hai bisogno di entrambe le visualizzazioni contemporaneamente, e questo è il problema che risolve Netwrix.

La piattaforma Netwrix fornisce gestione della postura di sicurezza dei dati (DSPM) tramite 1Secure e scoperta e classificazione dei dati tramite Access Analyzer, coprendo dati sensibili in ambienti ibridi, comprese fonti che gli strumenti nativi di Microsoft non raggiungono, come array di archiviazione NetApp e bucket Amazon S3 tramite i più di 40 moduli di raccolta dati di Access Analyzer.

Per l'IA shadow specificamente, 1Secure fornisce visibilità sull'esposizione di Microsoft Copilot segnalando quali dati sensibili Copilot può accedere e presentando valutazioni del rischio per supportare decisioni informate sul rollout dell'IA.

Dal punto di vista dell'identità, le capacità di rilevamento e risposta alle minacce identitarie di Netwrix (ITDR) evidenziano picchi insoliti di accesso ai dati, modifiche ai permessi o modelli di autenticazione falliti che potrebbero indicare l'uso di strumenti di IA ombra.

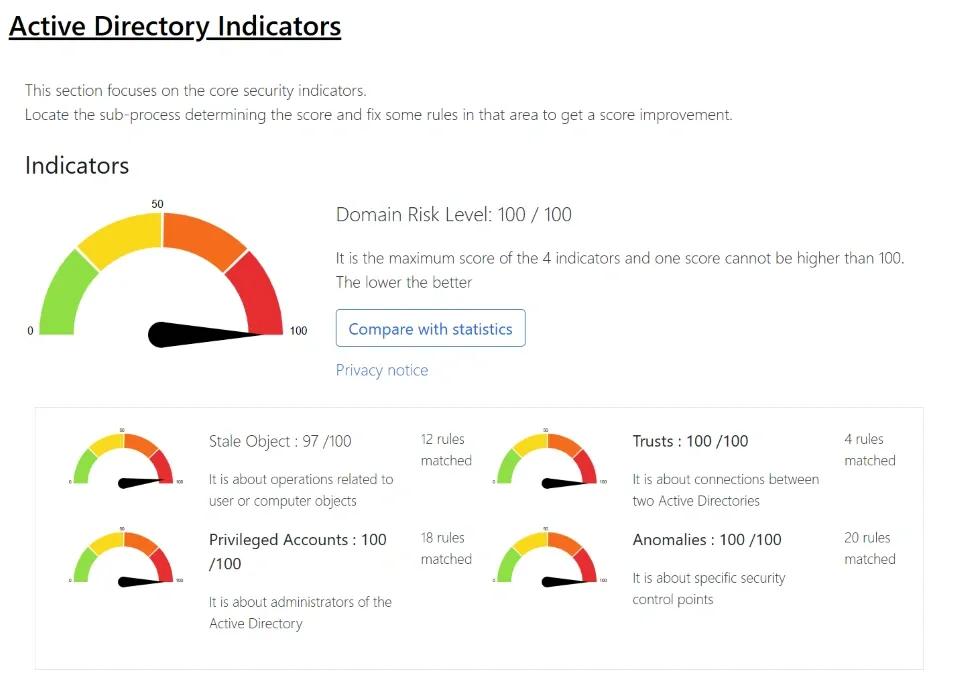

I cruscotti di valutazione del rischio evidenziano i problemi di igiene dell'identità che rendono l'IA ombra più pericolosa. Pensa a conti dormienti, privilegi eccessivi e lacune di sincronizzazione tra Active Directory on-premises e Entra ID.

Netwrix è progettato per un rapido ritorno sugli investimenti. 1Secure offre risultati ad alto impatto fin dal primo giorno senza implementazioni complesse, mentre Netwrix Auditor fornisce report pronti all'uso e leggibili dall'uomo, in modo che i team possano iniziare a rispondere alle domande di audit sull'accesso ai dati relativi all'IA in pochi minuti anziché in ore.

La reportistica di conformità si mappa direttamente ai framework PCI DSS, HIPAA, SOC 2, GDPR e CMMC, quindi la prova richiesta dal tuo revisore è un report, non un esercizio manuale di raccolta delle prove.

Se il tuo team ha bisogno di visibilità sui rischi dell'IA ombra ma non può aspettare un progetto di implementazione di sei mesi, hai bisogno di una piattaforma che inizi a fornire risposte fin dal primo giorno.Richiedi una demo di Netwrix per iniziare.

Domande frequenti sui rischi di sicurezza dell'IA ombra

Come dovremmo gestire i dipendenti che utilizzano account personali di IA per lavoro?

L'uso di account di IA personale rappresenta un significativo percorso di esposizione dei dati. Invece di approcci punitivi, concentrati sulla comprensione del motivo per cui i dipendenti preferiscono account personali e affronta quelle lacune.

Le ragioni comuni includono un accesso più rapido, migliori funzionalità o frustrazione con i processi di approvazione degli strumenti aziendali. Fornisci alternative di intelligenza artificiale aziendale che corrispondano alle capacità degli strumenti personali, semplifica il tuo processo di approvazione per le nuove funzionalità di intelligenza artificiale e comunica chiaramente i rischi senza creare una cultura della paura.

Possiamo semplicemente bloccare gli strumenti di intelligenza artificiale a livello di rete?

Puoi bloccare i domini noti di IA al firewall o al proxy, ma non risolverà il problema. Nuovi strumenti di IA vengono lanciati costantemente, molti operano su infrastrutture condivise come AWS e Azure che non puoi bloccare in modo generale, e le funzionalità di IA sono sempre più integrate all'interno degli strumenti che hai già approvato.

Una piattaforma SaaS che il tuo team utilizza quotidianamente potrebbe aggiungere un assistente AI da un giorno all'altro senza avvisarti. Bloccare porta anche l'uso sottoterra: i dipendenti passano a dispositivi mobili su reti personali, il che elimina completamente la tua visibilità.

Microsoft Copilot conta come IA ombra se l'abbiamo licenziato?

Non se è stato implementato con una governance intenzionale, ma può comunque creare rischi simili all'IA ombra. Copilot eredita i permessi che gli utenti già hanno nel tuo ambiente Microsoft. Se il tuo modello di permessi è eccessivamente permissivo, Copilot può rivelare dati sensibili a cui gli utenti tecnicamente avevano accesso, ma che non avrebbero mai trovato manualmente.

Non è AI ombrosa nel senso tradizionale, ma l'esito dell'esposizione dei dati è lo stesso. Prima di implementare Copilot, controlla chi ha accesso a cosa e pulisci prima i permessi eccessivi.

Qual è la prima cosa che dovrei fare se oggi non abbiamo un programma di IA ombra?

Inizia con la scoperta, non con la politica. Scrivere una politica di utilizzo accettabile prima di capire quali strumenti stanno effettivamente utilizzando i dipendenti e perché porta a politiche che vengono ignorate.

Interroga i tuoi registri DNS e proxy per connessioni a domini noti di servizi AI, rivedi i consensi delle applicazioni OAuth in Entra ID e conduci un sondaggio anonimo chiedendo ai dipendenti quali strumenti AI utilizzano e quali problemi risolvono quegli strumenti.

Questo ti offre un'immagine realistica su cui costruire la governance piuttosto che un quadro teorico che nessuno segue.

Come posso sostenere la governance dell'IA ombra ai vertici?

Frame it in terms leadership already cares about: compliance risk, data exposure liability, and audit readiness. Most boards and executive teams don't need convincing that AI adoption is happening.

Devono capire che l'adozione di IA non gestita crea lacune di prova che gli auditor troveranno, rischi di gestione dei dati che i regolatori penalizzeranno e esposizione della proprietà intellettuale che i concorrenti potrebbero sfruttare.

Porta esempi specifici dal tuo ambiente se puoi, anche aneddoti dalla fase di scoperta, che hanno più peso delle statistiche di settore.

Condividi su

Scopri di più

Informazioni sull'autore

Dirk Schrader

VP della Ricerca sulla Sicurezza

Dirk Schrader è un Resident CISO (EMEA) e VP of Security Research presso Netwrix. Con 25 anni di esperienza nella sicurezza informatica e certificazioni come CISSP (ISC²) e CISM (ISACA), lavora per promuovere la cyber resilience come approccio moderno per affrontare le minacce informatiche. Dirk ha lavorato a progetti di cybersecurity in tutto il mondo, iniziando con ruoli tecnici e di supporto all'inizio della sua carriera per poi passare a posizioni di vendita, marketing e gestione prodotti sia in grandi multinazionali che in piccole startup. Ha pubblicato numerosi articoli sull'esigenza di affrontare la gestione dei cambiamenti e delle vulnerabilità per raggiungere la cyber resilience.

Scopri di più su questo argomento

Identità non umane (NHI) spiegate e come proteggerle

Leggi sulla Privacy dei Dati per Stato: Diversi Approcci alla Protezione della Privacy

Cos'è la gestione dei documenti elettronici?

Espressioni regolari per principianti: Come iniziare a scoprire dati sensibili

Condivisione esterna in SharePoint: Consigli per un'implementazione oculata